一文读懂Transformer:从原理到实践,揭开大模型的核心奥秘¶

过去几年中,人工智能(AI)的进步令人瞩目,从ChatGPT、Bard到Midjourney、Stable Diffusion,这些应用以惊人的语言理解与生成、图像创作和跨模态能力颠覆了人们对AI的想象。这些出色表现背后有一位默默耕耘的「幕后英雄」——Transformer架构。自2017年谷歌团队提出Transformer后,它迅速成为自然语言处理(NLP)和多模态AI模型的基石。理解Transformer的内部工作原理,有助于我们看清AI应用的本质和未来潜力。

本文将从基础概念、模型流程、关键模块、训练机制与实际应用场景五个方面,为你详细揭开Transformer的神秘面纱。

一、Transformer的诞生与意义¶

在Transformer出现之前,RNN(循环神经网络)和CNN(卷积神经网络)在NLP任务中表现一般。RNN擅长处理序列数据,但训练效率较低且难以捕捉长距离依赖信息;CNN虽适合图像处理,却不能很好适应变长输入的文本数据。为解决这些难题,谷歌团队在2017年的论文《Attention Is All You Need》中提出Transformer,核心创新在于「注意力机制(Attention)」代替序列依赖,从而实现并行计算、充分提取上下文联系。

Transformer的意义在于,它让大规模预训练成为可能。由于不再严格依赖序列计算,模型可以高效地处理海量文本数据,从中自动学习语义、句法和世界知识。这为后来的GPT系列、大型多模态模型奠定了基础。

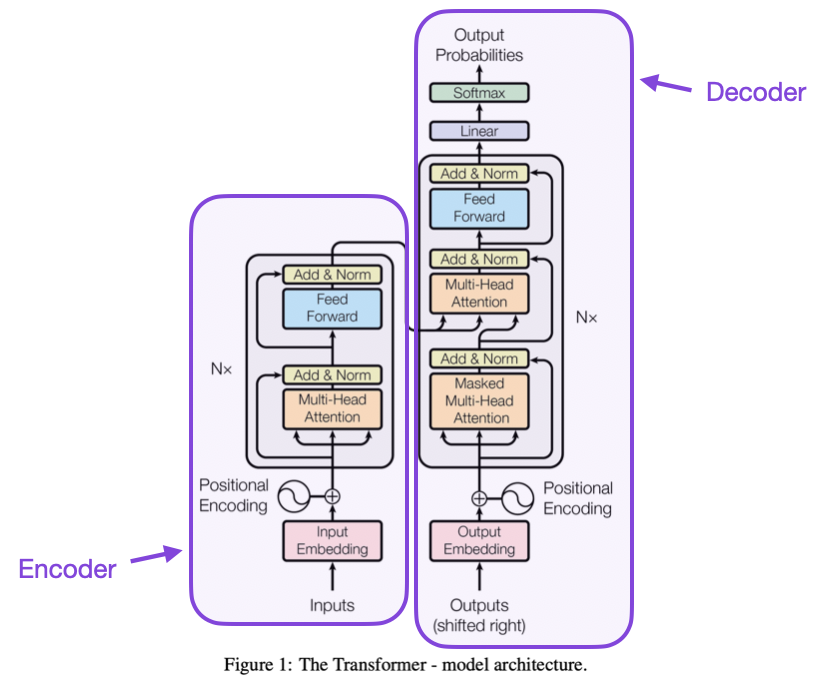

二、Transformer整体流程:从输入到输出¶

让我们先从宏观层面看看Transformer处理一段文本的过程:

-

分词(Tokenization):

将输入文本拆分为大量「标记」(token)。这些token可能是完整词语,也可能是子词片段、标点符号或字符子集。Token通常基于BPE(Byte-Pair Encoding)或SentencePiece等算法生成,以在字词级和字符级之间取得平衡,使模型能处理未知词汇和不同语言。 -

词嵌入(Embedding)与位置编码(Positional Encoding):

每个token被映射为一个高维向量(如数千维)。这些向量在语义空间中具有一定结构,相似含义的词嵌入彼此接近。 此外,Transformer本身对词序没有内在理解,因此需要加入位置编码(Positional Encoding)向量,使模型能够区分「猫坐在桌上」与「桌子坐在猫上」的差别。位置编码通常采用正弦和余弦函数,以在任意序列长度下保有位置信息。 -

多头注意力(Multi-Head Attention):

输入序列的嵌入向量进入关键模块——注意力层。 - 在注意力中,每个token都会生成「查询(Query)」、「键(Key)」和「值(Value)」三个向量。

- 对于序列中的任意两个token,查询向量与键向量的点积决定了它们之间的相关性权重。这个权重用于加权值向量,从而在上下文中动态聚合信息。

-

多头注意力意味着不止一套Q、K、V映射,每个头专注于不同的语义或语法特征。例如,一个注意力头或许侧重动词与主语的关系,另一个头可能侧重地名与国家的关联。

-

前馈网络(Feed-Forward Network,FFN):

在注意力层之后,每个token的向量再通过一层非线性前馈网络处理。 - FFN对每个token独立处理,将其映射到更高维空间再映射回来,有点像对向量进行一系列特定问题的问答。

-

FFN帮助模型提取更抽象、更高级的特征。当注意力用于信息融合时,FFN则在融合后的表示上加强非线性变换,提升模型表示能力。

-

层堆叠(Stacking Layers):

Transformer通常由N层相同结构(多头注意力 + FFN + 残差连接与归一化)叠加而成。数据通过多轮交互不断丰富其表示。规模越大、层数越多,模型捕捉复杂语义的能力越强。 -

输出层与概率分布(Softmax):

在处理完成后,模型需要预测下一个词的概率分布。通过一组映射回词表的权重矩阵(unembedding matrix)和Softmax函数,将高维向量映射到词汇表中每个token的概率上。 Softmax确保所有概率和为1,高值对应高概率单词。通过多次迭代预测与抽样,模型即可生成连贯自然的文本。

三、Attention机制的内核详解¶

注意力机制是Transformer的灵魂所在。它不再依赖序列顺序,而是让模型在任意时刻参考上下文中所有位置的词语。

主要分为以下几个方面:

- 点积注意力:Q与K的点积决定相关性,输出是对V的加权平均。

- 多头注意力:将Q、K、V向量分拆为多份,每份独立执行注意力计算,再将结果拼接回去。这样模型可同时从多个「视角」理解文本。

- 掩码(Masking):在语言模型训练中,预测下一个词时,需要屏蔽未来词语的信息以防作弊。这通过在注意力权重中给未来token赋零权重实现。

四、训练与预训练:为什么Transformer能如此「聪明」?¶

Transformer的强大来自于预训练阶段,它在海量文本上学习语言统计规律、语法结构和概念关联。

- 无监督预训练:在无标签的数据中预测下一个词是天然任务,不需昂贵的人工标注。模型在大规模语料上训练,有效地「阅读」了互联网上数以百亿计的句子。

- 微调(Fine-Tuning):在预训练基础上,通过少量有监督数据微调模型,可适应特定任务(如问答、翻译、摘要)。

- 指令微调与RLHF(基于人类反馈的强化学习):如ChatGPT背后使用RLHF,让模型更符合人类期望,与用户更自然交互。

五、应用与前景:从文本到多模态¶

Transformer不止于NLP,它已被扩展到图像、音频乃至多模态领域。

案例:

- 文本到图像生成(如Midjourney、Stable Diffusion):将文本描述嵌入成向量,再使用Transformer引导扩散模型生成对应的图像。

- 语音合成与语音识别:将音频分片作为输入token,并通过注意力机制在时间维度捕捉声学特征。

- 跨模态搜索与问答:将图像和文本统一映射到多模态空间中,让模型「看图说话」成为现实。

随着计算资源与优化算法的进步,Transformer及其变体将持续扩张规模并融入更多数据类型,朝着通用人工智能(AGI)的愿景前进。

总结¶

Transformer是一座桥梁,从传统的序列模型迈向并行、高效的注意力机制,为大型预训练模型的诞生铺平道路。在Transformer的支持下,大模型在语言、图像和多模态任务上不断突破,令AI从「模仿工具」进化为具备语义理解与创造力的智能体。

理解Transformer,你将更深刻地领会ChatGPT、Bard、Midjourney等应用背后的原理:它们的神奇源于对语言和数据模式的深度捕捉,以及在广阔数据中历练而来的智慧。

在这场AI技术迭代中,Transformer的影响才刚刚开始。当你再次与AI聊天、让AI创作图像,或让其理解多模态信息,不妨记住,其背后正有Transformer在默默驱动着这一切。

如果您对人工智能和量化金融的结合感兴趣,欢迎加入LLMQuant社区,共同探索人工智能在量化投资领域的应用。

关于LLMQuant¶

LLMQuant是由一群来自世界顶尖高校和量化金融从业人员组成的前沿社区,致力于探索人工智能(AI)与量化(Quant)领域的无限可能。我们的团队成员来自剑桥大学、牛津大学、哈佛大学、苏黎世联邦理工学院、北京大学、中科大等世界知名高校,外部顾问来自Microsoft、HSBC、Citadel、Man Group、Citi、Jump Trading、国内顶尖私募等一流企业。